AI i bezpieczeństwo danych: równowaga między ochroną a prywatnością

Sztuczna inteligencja (AI) odgrywa coraz większą rolę w procesach biznesowych. Wraz z jej rozwojem rośnie też ryzyko naruszenia bezpieczeństwa danych. Organizacje na całym świecie mierzą się dziś z wyzwaniem: jak korzystać z nowoczesnych narzędzi, takich jak Copilot w chmurze czy aplikacje AI od zewnętrznych dostawców, nie narażając wrażliwych informacji? Znalezienie równowagi między innowacyjnością a ochroną danych wymaga przemyślanej strategii. W tym artykule Frederik Stengaard, ekspert ds. bezpieczeństwa danych w Fellowmind, omawia największe zagrożenia oraz najlepsze praktyki, które pomagają bezpiecznie wdrażać AI w środowisku pracy.

Potencjalne ryzyko związane z nadmiernym udostępnianiem

Frederik Stengaard, ekspert ds. bezpieczeństwa danych w Fellowmind, podkreśla, że jednym z największych zagrożeń przy wdrażaniu AI jest nadmierne udostępnianie informacji.

„Narzędzia AI, zwłaszcza takie jak Copilot, mogą nieświadomie uzyskać dostęp do danych wrażliwych i zastrzeżonych, jeśli nie wdrożono odpowiednich zabezpieczeń” – wyjaśnia Frederik. „To z kolei może prowadzić do poważnych konsekwencji – od naruszenia przepisów RODO po ujawnienie kluczowych tajemnic firmowych, takich jak metody produkcji.”

Pierwsza linia obrony: identyfikacja kluczowych danych

Jak podkreśla Frederik, podstawą skutecznej ochrony jest określenie, które informacje mają dla organizacji krytyczne znaczenie.

„Nazywamy je klejnotami koronnymi – to dane i systemy, które wymagają najwyższego poziomu zabezpieczeń” – mówi.

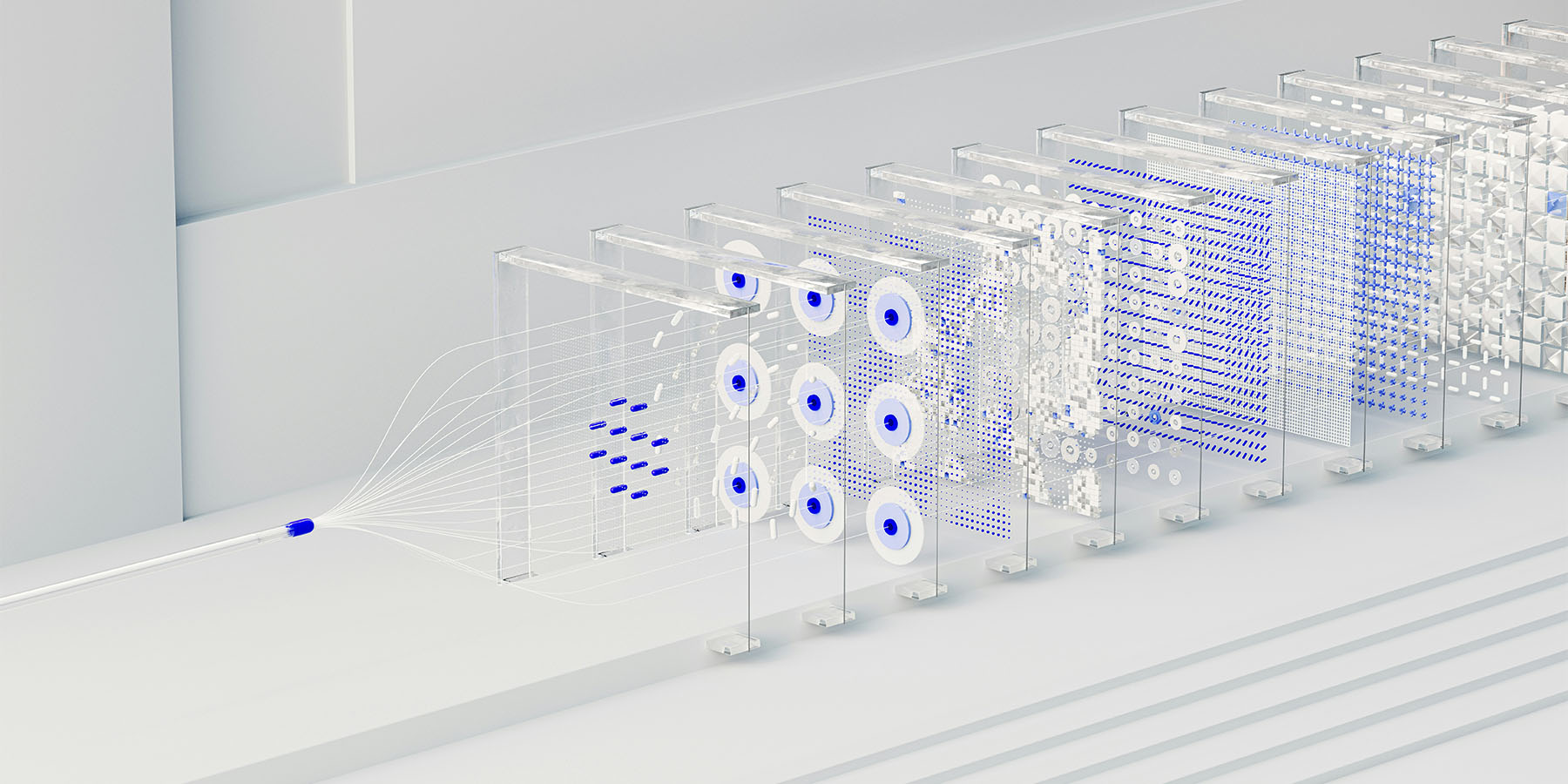

Przykładem mogą być rysunki inżynieryjne przesyłane na linię produkcyjną – tak wrażliwe pliki nie powinny być dostępne dla narzędzi AI. Rozpoznanie i odpowiednie zabezpieczenie tych kluczowych zasobów to fundament skutecznej strategii ochrony danych.

Zarządzanie zewnętrznymi narzędziami AI

Narzędzia AI dostarczane przez zewnętrznych dostawców stwarzają szczególne wyzwania w zakresie ochrony danych.

„Używanie narzędzi, takich jak generatory obrazów, bez odpowiednich umów dotyczących transferu danych może otworzyć furtkę do potencjalnych wycieków informacji” – wyjaśnia Frederik Stengaard.

Brak przejrzystości w sposobie przetwarzania danych przez takie narzędzia zwiększa ryzyko – zwłaszcza jeśli wrażliwe informacje mogą trafić do podmiotów zewnętrznych bez odpowiednich zabezpieczeń.

Dlatego wiele organizacji decyduje się ograniczyć lub całkowicie zakazać korzystania z zewnętrznych usług AI.

Wdrożenie zasad, które ograniczają zakres danych umieszczanych w poleceniach i przetwarzanych z użyciem tych narzędzi, ma kluczowe znaczenie w ograniczaniu ryzyka związanego z narażeniem danych.

Bez jasno określonych ograniczeń dane organizacji mogą zostać przechowywane i przetwarzane poza jej kontrolą, co niesie poważne zagrożenia dla bezpieczeństwa.

Najlepsze praktyki dotyczące bezpiecznej integracji AI

Podczas integracji AI z operacjami biznesowymi kluczowe jest przestrzeganie sprawdzonych zasad ochrony danych. Frederik Stengaard wskazuje cztery najważniejsze obszary:

-

Porządki w dostępach do danych

Upewnij się, że prawa dostępu do danych są aktualne, a stare linki udostępniania zostały usunięte z publicznych środowisk. To podstawowy krok w zapobieganiu przypadkowemu ujawnieniu informacji. -

Kategoryzacja danych

Podziel dane na kategorie: publiczne, wewnętrzne i poufne. Dzięki temu możesz zastosować odpowiednie zabezpieczenia dla każdej grupy i jasno określić, które informacje wymagają szczególnej ochrony. -

Wdrożenie prewencyjnych zabezpieczeń

Korzystaj z narzędzi zapobiegania utracie danych (DLP – Data Loss Prevention). Ograniczają one możliwość udostępniania wrażliwych informacji narzędziom AI lub wprowadzania ich w zapytaniach.

„Takie rozwiązania są kluczowe, aby uniknąć nieświadomego złamania zasad bezpieczeństwa przez użytkowników” – podkreśla Frederik. -

Współpraca z doświadczonym partnerem

Zaufani partnerzy, tacy jak Fellowmind, pomagają skutecznie chronić dane na każdym etapie wdrażania AI. Oferujemy dostosowane rozwiązania, tworzymy jasne zasady zapobiegające wyciekom danych i wdrażamy systemy, które wcześnie wykrywają zagrożenia. Dzięki temu możesz skoncentrować się na innowacjach, nie martwiąc się o bezpieczeństwo informacji.

Podsumowanie: bezpieczeństwo danych w erze AI – kluczowy priorytet

Wraz z rosnącą obecnością narzędzi AI w środowisku pracy ochrona danych staje się ważniejsza niż kiedykolwiek.

Bezpieczna integracja AI wymaga wielowarstwowego podejścia – od ograniczania dostępu do kluczowych informacji po wdrażanie skutecznych środków zapobiegawczych.

Stosując najlepsze praktyki, takie jak:

-

klasyfikacja danych,

-

uporządkowanie istniejących środowisk,

-

świadome zarządzanie narzędziami AI od zewnętrznych dostawców,

organizacje mogą skutecznie korzystać z możliwości sztucznej inteligencji, minimalizując ryzyko naruszeń bezpieczeństwa.

„AI daje niesamowity potencjał w zakresie innowacyjności, ale należy ją wdrażać ostrożnie. Zrozumienie i ochrona danych o kluczowym znaczeniu to pierwszy krok do upewnienia się, że korzystanie z AI nie odbywa się koszem bezpieczeństwa i prywatności” – podsumowuje Fredrik.

Ogromny potencjał wzrostu produktywności dzięki zastosowaniu sztucznej inteligencji

Raport AI Survey przedstawia, jak sztuczna inteligencja zmienia miejsce pracy poprzez zwiększenie produktywności i wspieranie innowacji. Zgodnie z raportem, znaczący wzrost popularności AI odnotowano wśród firm zatrudniających 300 lub więcej pracowników, a 89% z nich dostosowało budżety do integracji AI.